newspaper3k - ニューススクレイピングパッケージ

By khoanc, at: 2023年8月30日15:25

予想読書時間: __READING_TIME__ 分

はじめに

今日の急速に変化するデジタル時代において、最新のニュースや情報を常に最新の状態に保つことは、これまで以上に重要です。インターネットはリアルタイムデータの宝庫として機能しており、ウェブスクレイピングはこの情報を活用するための強力なテクニックとして台頭してきました。ウェブスクレイピングは、ウェブサイトからデータを自動的に抽出することで、洞察を収集し、トレンドを監視し、情報に基づいた意思決定を可能にします。

既にスクレイパーのブログ記事で多くのスクレイパーパッケージを紹介していますので、後でご覧になりたい方はそちらをご覧ください。

ニューススクレイピングの分野で注目を集めているもう一つの優れたツールは、「newspaper3k」Pythonパッケージです。効率性とシンプルさを念頭に設計されたnewspaper3kは、開発者が幅広いソースからニュース記事を簡単にスクレイピングできるようにします。この記事では、newspaper3kの詳細を掘り下げ、効率的なニューススクレイピングのための潜在能力を解き放つ包括的なガイドを提供します。

newspaper3kの概要

Newspaper3kは、汎用性が高く使いやすいPythonパッケージとして際立っています。様々なオンライン出版物、ブログ、ウェブサイトからのニュース記事のスクレイピングに特化して設計されています。newspaper3kは、その堅牢な機能により、複雑な手動データ抽出の必要性を排除し、ユーザーは収集された情報からの洞察の抽出に集中できます。

主な機能と利点:

- 記事抽出:newspaper3kの主要な強みの1つは、ニュース記事から重要な情報を正確に抽出する能力です。これには、記事のタイトル、著者、公開日、主要なコンテンツなどの詳細が含まれます。

- 言語検出:newspaper3kは、高度な自然言語処理技術を使用して、記事の言語を自動的に検出します。この機能は、多言語のウェブサイトからコンテンツをスクレイピングする場合に特に役立ちます。

- キーワード抽出:基本的な記事の詳細に加えて、newspaper3kは記事内のキーワードと重要な用語を特定できます。これは、分類、トピック分析、コンテンツの理解に役立ちます。

- 画像抽出:このパッケージは、記事に関連付けられた画像も抽出でき、書かれたコンテンツに付随する視覚要素の包括的なスナップショットを提供します。

- 要約:newspaper3kは、記事の簡単な要約を生成する機能を提供し、コンテンツの要点の概要をすばやく提供します。

- ユーザーフレンドリーなAPI:開発者にとって、使いやすさは際立った機能です。直感的なAPIとドキュメントにより、初心者と経験豊富なプログラマーの両方が利用できます。

使いやすさ:熟練の開発者であっても、Pythonを始めたばかりの人であっても、newspaper3kは非常に簡単な実装を誇ります。ウェブスクレイピングの複雑さを抽象化し、ユーザーはスクレイピングされたデータへのアクセスと活用に集中できます。このアクセシビリティにより、様々なレベルのコーディングの専門知識を持つ個人にとって理想的なツールとなります。

newspaper3kを使用すると、開発者はWebページのHTMLとCSS構造を手動で解析する複雑なプロセスを回避できます。代わりに、このパッケージはこれらのタスクをバックグラウンドで処理し、記事抽出のための合理化されたインターフェースを提供します。

本質的に、newspaper3kはスクレイピングプロセスを簡素化し、ユーザーが幅広いソースからニュース記事を迅速に収集することを可能にし、広範なコーディング知識を必要としません。

シンプルさを実践で:

newspaper3kの魅力的な側面の1つは、そのシンプルさです。ウェブスクレイピングを初めて使用する場合でも、その機能をすぐに活用できます。newspaper3kを使用してニュース記事から情報を抽出する方法の基本的な例を見てみましょう。

from newspaper import Article

# ニュース記事のURLを使用してArticleオブジェクトをインスタンス化

article_url = "https://example.com/news-article"

article = Article(article_url)

# 記事をダウンロードして解析

article.download()

article.parse()

# 情報を抽出

title = article.title

author = article.authors

publish_date = article.publish_date

content = article.text

# 抽出された情報を表示

print("Title:", title)

print("Author:", author)

print("Publish Date:", publish_date)

print("Content:", content)

わずか数行のコードで、newspaper3kはニュース記事から重要な情報を取得して整理し、ウェブスクレイピングに対するユーザーフレンドリーなアプローチを示しています。

インストールと設定

newspaper3kを使用したニューススクレイピングの世界に飛び込む前に、システムにパッケージを設定する必要があります。幸いなことに、インストールプロセスは簡単です。開始するには、次の手順に従ってください。

-

Pythonのインストール:システムにPythonがインストールされていることを確認します。インストールされていない場合は、公式Pythonウェブサイト(https://www.python.org/)からダウンロードしてインストールできます。

-

newspaper3kのインストール:ターミナルまたはコマンドプロンプトを開き、次のpipコマンドを使用してnewspaper3kをインストールします。

pip install newspaper3k

-

依存関係のインストール:システムによっては、newspaper3kが正しく機能するために追加の依存関係をインストールする必要がある場合があります。たとえば、Ubuntuベースのシステムでは、次のパッケージをインストールできます。

sudo apt-get install libxml2-dev libxslt-dev

-

インストールのテスト:newspaper3kが正しくインストールされていることを確認するために、ターミナルで簡単なPythonスクリプトを実行します。

from newspaper

import Article

article = Article("https://example.com")

print(article.title)

ターミナルに記事のタイトルが表示されたら、おめでとうございます。newspaper3kは正常にインストールされ、使用準備ができました!

基本的な使用方法

newspaper3kが稼働しているので、基本的な使用方法を見てみましょう。ニュース記事のスクレイピングと、そこから関連情報を抽出するプロセスについて説明します。

-

モジュールのインポート:

最初に、Pythonスクリプトの先頭で必要なモジュールをインポートします。

from newspaper import Article -

Articleオブジェクトの作成:

特定のニュース記事をスクレイピングするには、

Articleオブジェクトを作成し、引数として記事のURLを指定する必要があります。article_url = "https://example.com/news-article"

article = Article(article_url) -

ダウンロードと解析:

次に、記事をダウンロードして解析し、そのコンテンツを抽出する必要があります。

article.download()

article.parse() -

情報の抽出:

記事がダウンロードされ、解析されたら、利用可能な属性を使用して様々な情報を簡単に抽出できます。

- タイトル:

article.title - 著者:

article.authors - 公開日:

article.publish_date - コンテンツ:

article.text

例:

title = article.title

author = article.authors

publish_date = article.publish_date

content = article.text - タイトル:

-

抽出された情報の表示:

最後に、分析またはさらなる処理のために抽出された情報を表示できます。

print("Title:", title)

print("Author:", author)

print("Publish Date:", publish_date)

print("Content:", content)

これらの手順により、newspaper3kを使用してニュース記事から情報を正常にスクレイピングして抽出しました。この基本的な使用方法により、パッケージが提供する高度な機能とカスタマイズオプションを探索するための堅実な基盤が提供されます。

高度な機能

newspaper3kは基本的なニュース記事のスクレイピングに優れていますが、その汎用性と有用性を高める高度な機能も提供しています。これらの機能の一部を見てみましょう。

-

言語検出:

新聞記事は様々な言語で書かれています。newspaper3kは記事の言語を自動的に検出でき、これは多言語コンテンツのスクレイピングに特に役立ちます。検出された言語にアクセスするには:

detected_language = article.meta_lang -

キーワード抽出:

記事からキーワードを抽出すると、そのコンテンツに関する貴重な洞察が得られます。newspaper3kを使用すると、上位キーワードを簡単に取得できます。

article.nlp() # NLPを実行

keywords = article.keywords -

画像抽出:

画像は多くの場合、ニュース記事に付随します。newspaper3kを使用すると、記事に関連付けられたメイン画像を抽出できます。

main_image_url = article.top_image -

例外処理:

Webスクレイピングでは、ネットワークエラーや無効なURLなど、様々な問題が発生する可能性があります。newspaper3kは、そのような状況を適切に処理するための例外処理メカニズムを提供します。コードをtry-exceptブロックで囲みます。

from newspaper import ArticleException

try:

# スクラピングコードはこちら

raise ArticleException('test')

except ArticleException as e:

print("Error:", e)

これらの高度な機能を活用することで、より包括的で有益なスクレイピングアプリケーションを作成できます。言語トレンドの分析、重要なトピックの特定、関連画像の収集のいずれであっても、newspaper3kは必要なツールを提供します。

カスタマイズと設定

Newspaper3kの柔軟性は、そのカスタマイズオプションにまで及びます。スクレイピングのニーズに合わせてパッケージの様々な側面を設定できます。

-

設定オプション:

設定を変更することで、newspaper3kの動作を設定できます。たとえば、リソースを節約するために、全文解析やメモ化などの特定の機能を無効にすることができます。

from newspaper import Config

config = Config()

config.memoize_articles = False

config.fetch_images = False -

ユーザーエージェントのスプーフィング:

一部のウェブサイトでは、ユーザーエージェントに基づいてコンテンツの制限や変更を行う場合があります。検出を回避するために、カスタムユーザーエージェントを設定できます。

config = Config()

config.browser_user_agent = "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3" -

出力形式:

publish_date_formatter設定オプションを使用して、日付の出力形式を変更できます。config = Config()

config.publish_date_formatter = lambda date: date.strftime("%Y-%m-%d %H:%M:%S")

要件に合わせてnewspaper3kを設定することで、スクレイピングの取り組みが効率的で効果的であることを確認できます。

これらの高度な機能とカスタマイズオプションを探索するにつれて、newspaper3kの潜在能力を最大限に引き出し、ニューススクレイピングプロジェクトを新しいレベルの洗練へと高めることができます。この記事の次のセクションでは、倫理的なスクレイピングと効率的な大規模スクレイピングのベストプラクティスについて詳しく説明し、成功したニュースデータ抽出のための包括的なツールキットを提供します。

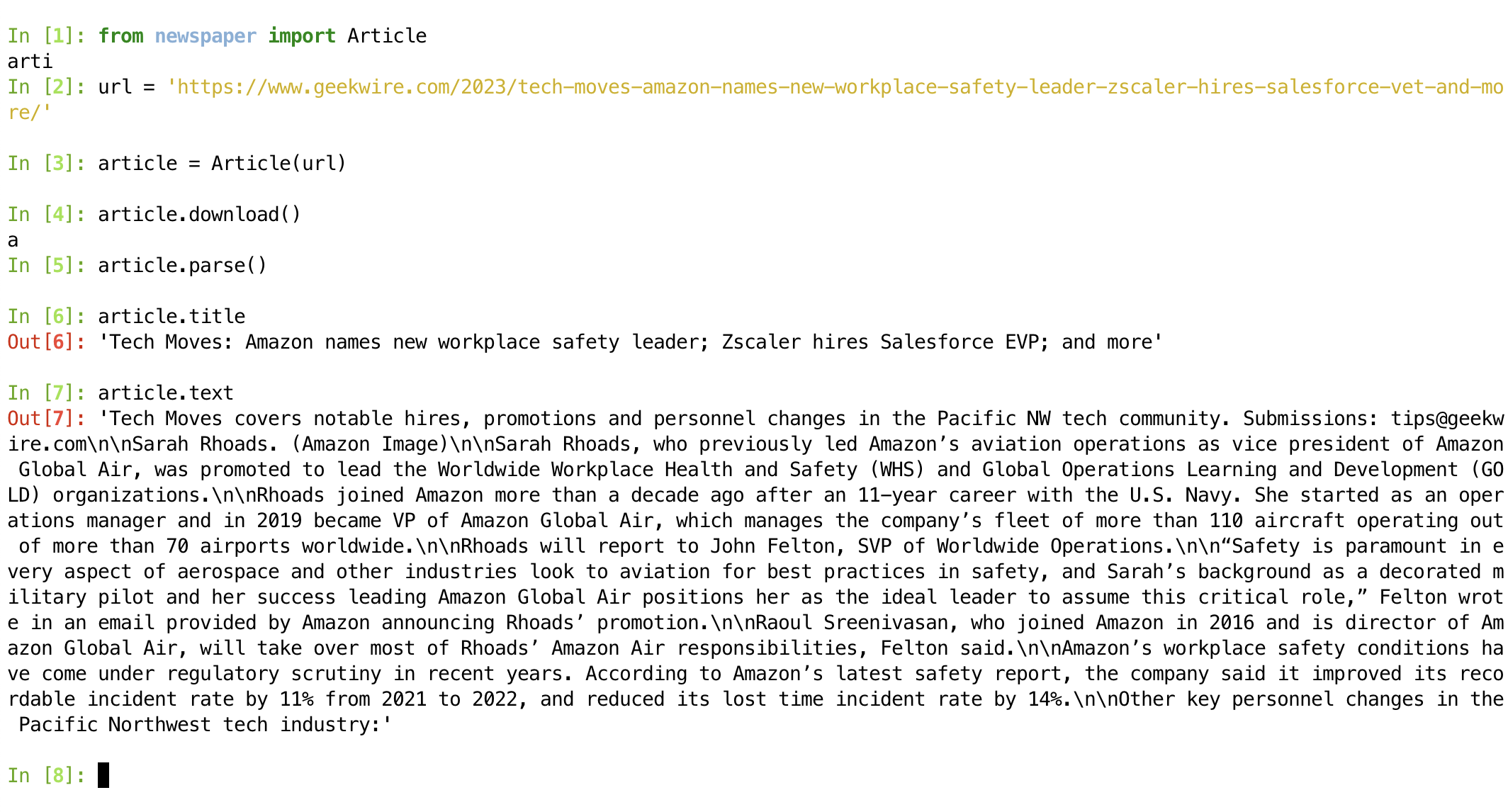

発生する可能性のあるエラー

発生する可能性のある2つの主要な問題があります。

- JavaScriptでレンダリングされたコンテンツ:ウェブサイトがコンテンツのレンダリングにJavaScriptを大きく依存している場合、newspaper3kは主に静的なHTMLを扱うため、データを正しく抽出できない可能性があります。

- テキストが不正な場合:多くのテキストコンテンツを含むサイト/URLがありますが、解析された

Article.textの結果が不正です。例:https://www.geekwire.com/2023/tech-moves-amazon-names-new-workplace-safety-leader-zscaler-hires-salesforce-vet-and-more/

大規模スクレイピングの処理

Webスクレイピングプロジェクトが成長するにつれて、様々なソースからの多数の記事を扱うことになる場合があります。大量のデータを効率的に管理するには、慎重な計画と考慮が必要です。newspaper3kを使用した大規模ニューススクレイピングを処理するためのいくつかの戦略を次に示します。

-

リクエストのスロットリング:

ウェブサイトには、レート制限や反スクレイピング対策が導入されている場合があります。サーバーに過負荷をかけることやブロックされるのを避けるために、リクエスト間に遅延を導入することでリクエストのスロットリングを実装します。

import time delay = 2 # リクエスト間の遅延(秒)

for article_url in article_urls:

article = Article(article_url)

article.download()

article.parse()

# 処理コードはこちら...

time.sleep(delay) -

バッチ処理:

スクレイピングする記事が大量にある場合は、バッチ処理を実装することを検討してください。記事を小さなバッチにグループ化し、各バッチを順番に処理してリソースを効率的に管理します。

マルチスレッドはネイティブでサポートされています。 -

非同期スクレイピング:

非同期プログラミングにより、複数のリクエストを同時に送信でき、スクレイピングの速度が向上します。

asyncioやaiohttpなどのライブラリは、非同期スクレイピングのためにnewspaper3kと組み合わせることができます。 -

データストレージ:

スクレイピングされたデータをどのように保存するかを決定します。データベースやCSVやJSONなどのファイル形式を使用すると、情報を整理して簡単にアクセスできます。

-

エラー処理とログ:

大規模なスクレイピングでは、様々なエラーが発生する可能性があります。問題を追跡し、効率的にトラブルシューティングするために、徹底的なエラー処理とログメカニズムを実装します。

これらの戦略を実装することで、効率性と倫理的なスクレイピングプラクティスへの準拠を維持しながら、ニューススクレイピングプロジェクトを自信を持って拡張できます。

ベストプラクティス

newspaper3kを使用したニューススクレイピングの取り組みを開始する際には、倫理的で責任あるデータ抽出を確保するために、ベストプラクティスに従うことが不可欠です。

-

ウェブサイトポリシーを尊重する:

常にウェブサイトの利用規約とスクレイピングポリシーを確認し、遵守してください。スクレイピングを明示的に禁止しているウェブサイト、またはスクレイピングに反対する条件があるウェブサイトのスクレイピングは避けてください。

-

レート制限:

過剰なリクエストでウェブサイトに過負荷をかけるのを避けるために、レート制限と遅延を実装します。責任あるスクレイピングは、データを取得しているウェブサイトの整合性を維持します。

-

ユーザーエージェントとrobots.txt:

スクレイピングボットを識別するための適切なユーザーエージェントを設定し、サイトのどの部分をクロールできるかを指定するウェブサイトの「robots.txt」ファイルを尊重します。

-

著作権と帰属:

スクレイピングされたデータを公開して配布する予定がある場合は、コンテンツを元のソースに帰属させ、著作権法を尊重してください。

-

データ使用契約:

商業目的で、または他者のためにデータをスクレイピングする場合は、データの収集、保存、使用の条件を概説するデータ使用契約を作成することを検討してください。

これらのベストプラクティスを遵守することにより、ウェブサイトの整合性を維持し、スクレイピングプロジェクトを法的問題から保護し、データスクレイパーとコンテンツプロバイダー間の良好な関係を育むことができます。

結論

Webスクレイピングの分野では、newspaper3kはニュース記事の抽出に特化した汎用性が高く使いやすいPythonパッケージとして輝いています。この包括的なガイドを通じて、インストールと使用の基本から高度な機能、カスタマイズオプション、大規模スクレイピング戦略、責任あるスクレイピングのベストプラクティスまで、旅をしました。

この知識を身につければ、独自のニューススクレイピングプロジェクトに着手し、newspaper3kの力を活用してリアルタイム情報を収集し、洞察を抽出し、関心のある分野に貢献することができます。データ抽出の世界を探求し続ける際には、倫理的な基準を遵守し、スクレイピングするウェブサイトを尊重することを忘れないでください。ニュースの世界はあなたの指先にあります。スクレイピングを始めましょう!